AIがAIをダメにする?チャットGPT登場後の世界と「デジタル汚染」のお話

皆さん、こんにちは!AI技術の面白さを分かりやすくお伝えするジョンです。最近、チャットGPTをはじめとする「生成AI(文章や画像などを自動で作ってくれるAI)」がすごい勢いで私たちの日常に入り込んできましたね。質問に答えてくれたり、文章を考えてくれたり、本当に便利で驚かされることばかりです。

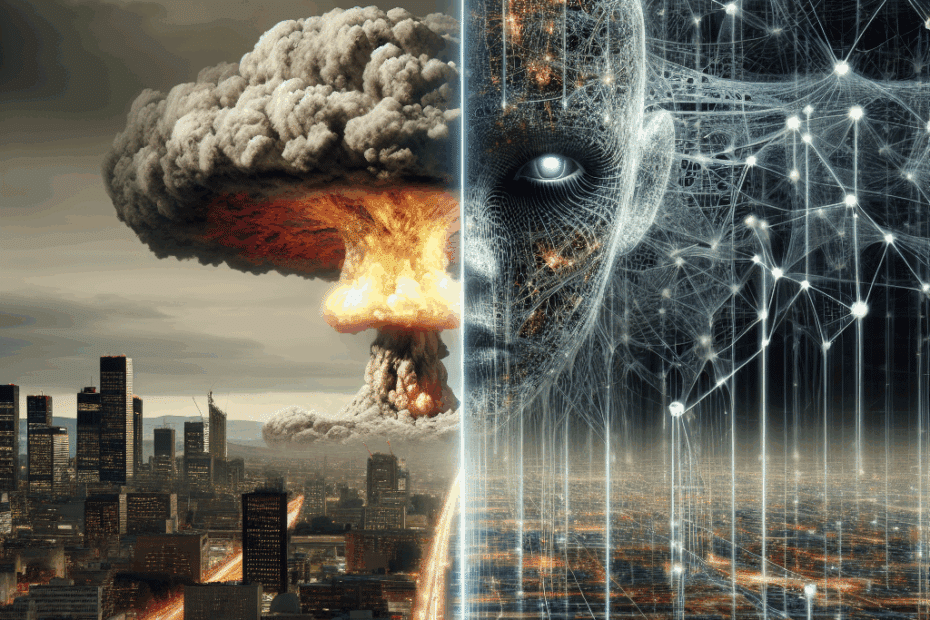

でも、このAI技術の急速な発展が、実は未来のAI開発にとって思わぬ「落とし穴」になるかもしれない、という話が専門家の間でささやかれているのをご存知でしたか?まるで、世界で最初の原子爆弾の実験が、その後の世界に良くも悪くも大きな影響を与え、元には戻れない変化をもたらしたように、チャットGPTの登場も、私たちのデジタル世界に大きな、そして元に戻せない変化をもたらした可能性がある、というのです。

今日は、このちょっと怖いけれど大切な「AIによるデジタル世界の汚染」という問題について、一緒に見ていきましょう。

「デジタル汚染」って、いったい何?

まず、AIがどうやって賢くなるか、簡単におさらいしてみましょう。AI、特にチャットGPTのような大規模言語モデル(たくさんの文章を読んで学習するAIのことです)は、インターネット上にある膨大な量のテキストデータ、例えばブログ記事、ニュース、小説などを「読んで」学習します。人間がたくさんの本を読んで知識を身につけるのに似ていますね。

ところが、チャットGPTのような生成AIが登場して以来、インターネット上にはAIが作った文章や情報がどんどん増え続けています。これ自体は、便利な情報が増えるという意味では良いことかもしれません。でも、問題はここからです。

もし、未来の新しいAIが、人間が作った情報だけでなく、AIが作った情報も一緒に学習してしまうとどうなるでしょうか?

- AIが作った情報の中には、まだ間違いが含まれていたり、微妙なニュアンスが欠けていたりすることがあります。

- また、AIが作った文章をAIが学習すると、だんだん内容が偏ってしまったり、質が落ちてしまったりする可能性があります。

例えるなら、きれいな水(人間が作った質の高い情報)に、少しずつ泥水(AIが作った情報、中には不確かなものも含む)が混ざっていくようなイメージです。最初は大丈夫でも、だんだん全体の水が濁ってしまう…これが「デジタル汚染」と呼ばれる現象です。

研究者たちは、このAIが生成したデータがインターネットにあふれることを「データ汚染」や「モデル汚染」と呼んでいて、これが将来のAI開発にとって大きな障害になるのではないかと心配しているのです。

「モデル崩壊」という怖い未来

AIがAIの作ったデータ(これを「合成データ」と呼んだりします)ばかりを学習し続けると、「モデル崩壊(model collapse)」という現象が起きるかもしれない、と言われています。

これは、AIが学習すればするほど、逆に賢さが失われていってしまう状態のこと。まるで、何度もコピーを繰り返した書類が、だんだん文字がかすれて読みにくくなってしまうのに似ています。AIが作り出す文章が、だんだん意味不明になったり、同じようなことばかり繰り返すようになったりするかもしれません。

もし本当にこんなことが起きたら、AIの進化は止まってしまうどころか、後退してしまうかもしれません。せっかく便利なAIが登場したのに、そのAI自身が未来のAIの成長を邪魔してしまうなんて、なんだか皮肉な話ですよね。

「低バックグラウンド鋼」から学ぶ教訓

この問題を考える上で、面白い例え話があります。それは「低バックグラウンド鋼(ていバックグラウンドこう)」という特別な鉄のお話です。

「低バックグラウンド鋼」とは、1945年以降の核実験によって大気中に放出された放射性物質の影響をほとんど受けていない、ごくわずかな鉄のことです。核実験が始まる前に作られた鉄や、古い沈没船から引き上げられた鉄などがこれにあたります。

なぜこんな鉄が重要なのでしょうか?実は、ガイガーカウンター(放射線量を測る機械)のような非常に精密な測定器を作るには、放射能レベルが極めて低い鉄が必要なのです。現代の製鉄方法では、どうしても大気中の放射性物質が微量に混入してしまうため、この「汚染されていない」古い鉄が非常に貴重なものとして扱われています。

AIの世界でも、これと同じことが起きるかもしれません。

つまり、AIが生成したコンテンツで「汚染」される前の、純粋な人間が作ったデータが、将来のAIを訓練するためには非常に価値のある「デジタル版の低バックグラウンド鋼」になる可能性があるのです。今のうちに、質の高い人間の手によるデータをしっかりと保存しておくことが、未来のAI開発にとって重要になるかもしれませんね。

私たちはどうすればいいの?

この「デジタル汚染」問題は、まだ始まったばかりで、解決策もはっきりとは見えていません。でも、いくつかの方向性が考えられています。

- 質の高い人間によるデータセットの確保:研究機関や企業が協力して、AI生成コンテンツの影響を受けていない、信頼できる大規模なデータセットを整備・保存していくこと。

- AI生成コンテンツの識別技術:AIが作った文章や画像を見分ける技術を開発し、学習データから除外したり、注意して扱ったりすること。

- 新しい学習方法の開発:合成データの影響を受けにくい、あるいは合成データを上手に活用できる新しいAIの学習方法を研究すること。

私たち一人ひとりができることは少ないかもしれませんが、AIが作る情報を鵜呑みにせず、情報源を確認する癖をつけるなど、情報の受け取り方について少し意識してみるだけでも違うかもしれませんね。

ジョンからのひとこと

チャットGPTの登場は、本当に画期的で、私たちの生活や仕事のあり方を大きく変える可能性を秘めています。でも、どんな強力な技術も、光と影があるものなんですね。今回の「デジタル汚染」の話は、AI技術とどう向き合っていくか、改めて考えさせられるきっかけになりました。

AIが私たちにとって本当に役立つパートナーであり続けるためには、こうした課題にも目を向けて、みんなで知恵を出し合っていくことが大切なんだと思います。未来のAIが、今のAIの「置き土産」に悩まされることなく、もっと賢く、もっと私たちの生活を豊かにしてくれるようになることを願っています。

この記事は、以下の元記事をもとに筆者の視点でまとめたものです:

The launch of ChatGPT polluted the world forever, like the

first atomic weapons tests