JonとLilaが独自の視点で語る対話形式の英語版はこちら 👉 [Read the dialogue in English]

What is context engineering? And why it’s the new AI architecture

導入

👋 AIの進化が加速する今、コンテキストエンジニアリングという新しいアプローチが登場し、AIシステムの設計を根本から変えようとしています。この技術は、単なるツールの改良ではなく、AIの「思考の土台」を再構築するものです。

コンテキストエンジニアリングとは、AIに与える文脈を体系的に設計する手法です。

これによりAIの出力精度が飛躍的に向上し、ビジネスや開発現場で実務効率が向上します。

この記事を読むと、従来のAI設計との違いを理解し、自分のプロジェクトにどう取り入れるかを判断できます。

AIを扱う中で「出力が安定しない」「文脈がずれる」と悩むことはありませんか。

そんな日常のイライラが、この新しいアーキテクチャで解決の兆しを見せています。技術者として現場で試行錯誤を繰り返すあなたにこそ、響くはずです。

🔰 記事レベル:技術者

🎯 こんな人におすすめ:AI開発者、プロンプト設計者、システムアーキテクトで、出力の再現性を高めたい実務担当者

✅ まず押さえる3点

- コンテキストエンジニアリングはAIの入力文脈を動的に構築する新手法

- 従来のプロンプト中心から、文脈全体の設計へシフト

- 実務で即活用可能で、出力の安定性とスケーラビリティを向上

元記事を確認すると、さらに深い洞察が得られます。

次は、この技術が生まれた背景から見ていきましょう。

背景と課題

AI開発の現場では、プロンプトの微調整だけでは限界を感じる場面が増えています。

大規模言語モデルが巨大化する一方で、入力の文脈不足が誤作動の原因となっています。

例えば、チャットボットでユーザー履歴を無視した応答が出るのは、日常の設計課題です。

従来のAIは静的なプロンプトに依存し、文脈の蓄積が不十分でした。

これがプロジェクトのスケール時にボトルネックを生み、技術者として頭を悩ませる要因です。

- 文脈の散逸:会話が長くなると初期情報が失われやすい

- 動的適応の欠如:ユーザー行動にリアルタイム対応できない

- リソース制約:全履歴を保持すると計算コストが爆発

コンテキストエンジニアリングはこの課題を、文脈の動的構築で解決します。

気になる仕組みの詳細は、次のセクションで深掘りします。

技術・内容解説

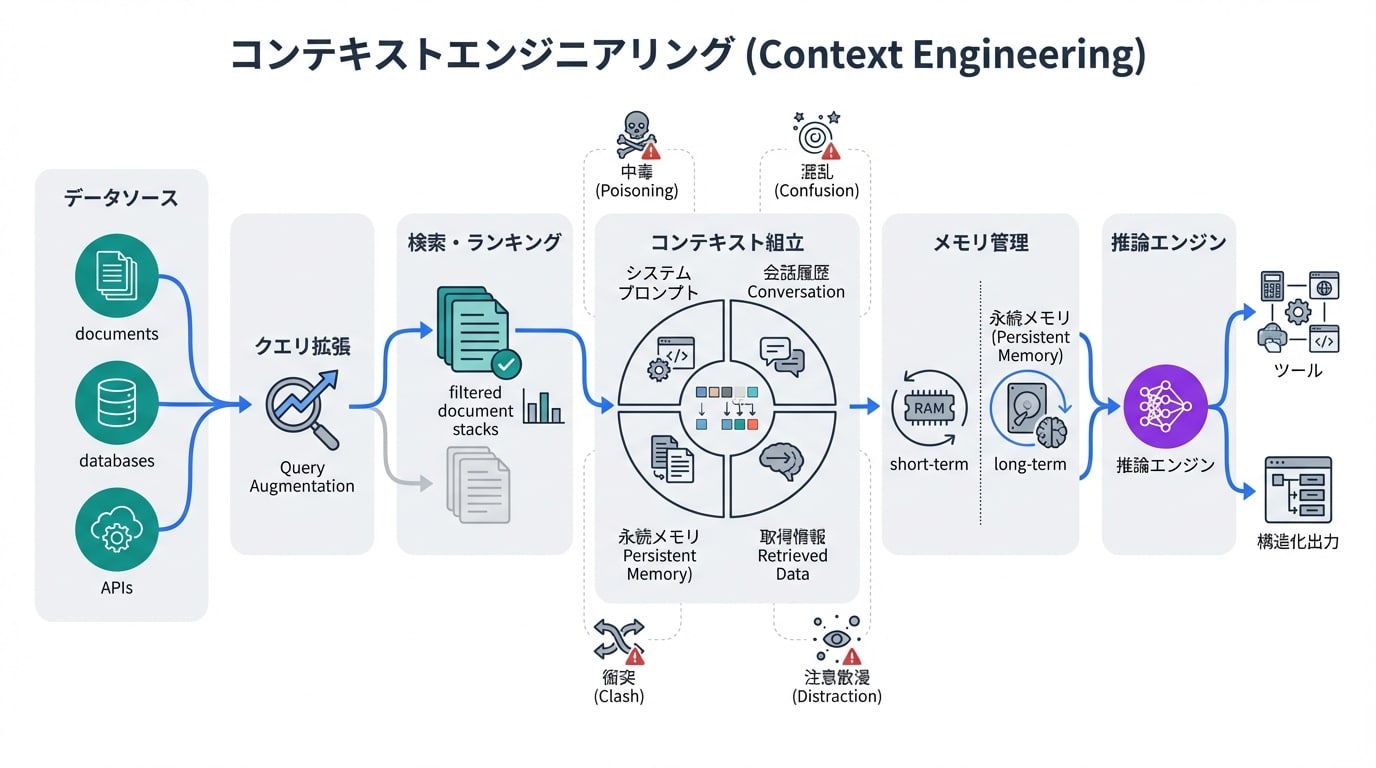

コンテキストエンジニアリングは、AIの入力として「静的プロンプト」から「動的文脈グラフ」への移行を核心とします。

これにより、AIは会話履歴、ユーザー属性、外部データを統合的に扱えます。

従来のプロンプトエンジニアリングが「一過性の指示」に留まるのに対し、文脈を永続化・最適化します。

| 項目 | 従来(プロンプト中心) | コンテキストエンジニアリング |

|---|---|---|

| 仕組み/流れ | 単発プロンプト入力→即時出力 | 文脈グラフ構築→動的更新→統合出力 |

| メリットの出方 | 短いタスクに強いが長期会話で劣化 | 長期一貫性が高く、スケール対応 |

| 制約/リスク前提 | トークン制限で情報損失 | 初期設計負荷増だが圧縮技術で緩和 |

実装では、文脈をベクトル化し、グラフデータベースで管理します。

これでAIの「記憶」が強化され、出力の論理的一貫性が保たれます。

❌ よくある誤解

- 「ただの長いプロンプトの延長」→正しくは動的グラフ構造で文脈を再構築

- 「計算コストが爆増する」→圧縮・選択アルゴリズムで効率化可能

- 「大規模モデル専用」→中小モデルでも文脈設計で効果発揮

ユーモアを交えて言うと、従来のAIは「金魚の記憶」でしたが、これは「象の記憶」にアップグレードです。

次に、専門用語をクリアに整理しましょう。

用語解説

- コンテキストエンジニアリング

- AIの入力文脈を体系的に設計・管理する手法。静的指示を超え、動的蓄積で出力精度を向上させます。

- プロンプトエンジニアリング

- AIへの指示文を最適化する技術。コンテキストエンジニアリングの基盤となります。

- 文脈グラフ

- 会話やデータをノード・エッジで表現した構造。AIの長期記憶をシミュレートします。

- トークン制限

- モデルが一度に処理できる入力量の上限。文脈圧縮で回避します。

- チェーン・オブ・ソート(Chain of Thought)

- 思考を段階的に記述し、複雑タスクを解くプロンプト技法。文脈構築に活用。

- ベクトル化

- テキストを数値ベクトルに変換。類似文脈の検索・統合を高速化します。

- 大規模言語モデル(LLM)

- 膨大なデータで訓練された生成AI。コンテキストエンジニアリングの対象。

- 動的更新

- リアルタイムで文脈を追加・修正する仕組み。会話適応性を高めます。

- 出力一貫性

- 長期対話で論理が崩れない状態。文脈設計の最大成果です。

- スケーラビリティ

- システム規模拡大時の安定性。グラフ管理で実現します。

これで基盤が固まりました。活用のインパクトを見ていきましょう。

インパクト・活用事例

技術現場では、カスタマーサポートAIで文脈保持により応答精度が向上します。

期待できるのは、ユーザー離脱率の低下と運用コスト削減です。

ただ、過度な期待は禁物。初期文脈設計のミスで逆効果になる場合もあります。

開発プロジェクトでは、コードレビューAIに過去コミットを文脈化し、バグ検知を強化。

期待は生産性向上ですが、機密データ漏洩リスクに注意が必要です。

クリエイティブ分野では、ストーリー生成で連続性を保ち、AIクリエーターのワークフローを革新。

人間の編集負担が減る一方、創造性の希薄化を防ぐバランスが求められます。

ビジネスではチャットボットが「会話記憶」を持ち、営業成約率向上の事例が出ています。

これらの事例から、技術者の設計力が鍵です。

実務導入のヒントは次で具体化します。

アクションガイド

まずは現在のプロンプトを文脈グラフに置き換える検証から始めましょう。

技術者向けに、即実装可能なステップを提示します。

🧾 保存用:確認チェックリスト

⏱ 5分でできる確認

- 既存プロンプトにユーザー履歴を追加記述

- 出力一貫性を手動で3クエリテスト

- トークン使用量をログ確認

⏳ 15分でできる確認

- 簡単なグラフDB(Neo4j無料版)で文脈ノード作成

- ベクトル埋め込みAPI(Hugging Face)でテスト統合

- 動的更新スクリプトをPythonでプロトタイプ

- 従来 vs 新で精度比較

📅 週1で見る指標

- 応答一貫性スコア(手動評価)

- 平均トークン削減率

- ユーザー満足度フィードバック

- エラー発生頻度推移

これをルーチン化すれば、現場力が格段に上がります。

未来の展望に目を向けましょう。

未来展望とリスク

コンテキストエンジニアリングは、AIエージェントの基盤となり、多剤システムとの連携が進むでしょう。

マルチモーダル文脈(テキスト+画像+音声)の統合が標準化されそうです。

一方、リスクとしてプライバシー侵害の懸念があります。文脈蓄積が個人データを増大させるためです。

計算リソースの依存も課題で、分散処理技術の進展が鍵となります。

公平性を保つバイアス検知メカニズムの組み込みも必要です。

技術者は倫理的設計を先取りすべきです。

全体を振り返るまとめへ。

まとめ

- コンテキストエンジニアリングはAIアーキテクチャの新標準、文脈動的構築で出力安定

- 従来プロンプトの限界を克服、実務スケーラビリティを向上

- 技術者としてグラフ管理と圧縮をマスター

- 次に調べる:文脈圧縮アルゴリズム(「context compression AI」で検索)

- グラフDB実装事例(Neo4j + LLMチュートリアル検索)

これであなたのAI設計が一歩進みます。

💬 あなたのプロジェクトでコンテキストエンジニアリングを試した結果、どう変わりましたか? コメントで共有を!

参照リンク・情報源

- コンテキストエンジニアリングの詳細解説(InfoWorld)

- AIアーキテクチャ関連論文(「context engineering LLM」で検索して確認)

- 実装事例(「Neo4j LLM context graph」で検索)

▼ 作業を時短するAIツール(無料枠あり)

無料で使えるAI検索・ファクトチェック

👉 Genspark

おすすめ用途:公開前に事実確認と一次情報の当たりを最短で取る

スライド・企画書の爆速作成(無料お試し可)

👉 Gamma

おすすめ用途:記事の要点をそのままスライド化して配布用に転用する

トレンド記事をショート動画に自動変換(無料トライアル)

👉 Revid.ai

おすすめ用途:記事構成からショート台本と動画素材をまとめて作る

顔出しなしで解説動画を自動生成(無料作成可)

👉 Nolang

おすすめ用途:図解や箇条書きから解説動画を最短で作る

タスクの完全自動化(無料プランからスタート)

👉 Make.com

おすすめ用途:記事公開→SNS投稿→記録→次タスク化 までを自動連携する

※上記リンクにはアフィリエイトが含まれる場合があり、無料枠や仕様は変更される可能性があります(最新情報は公式サイトをご確認ください)。