AIの性能評価に新風!AIクリエーターの道 ニュース:実世界タスク能力を測るxbench登場! AIの進化を捉える革新的なベンチマークとは? #AIベンチマーク #xbench #AI評価

動画で解説

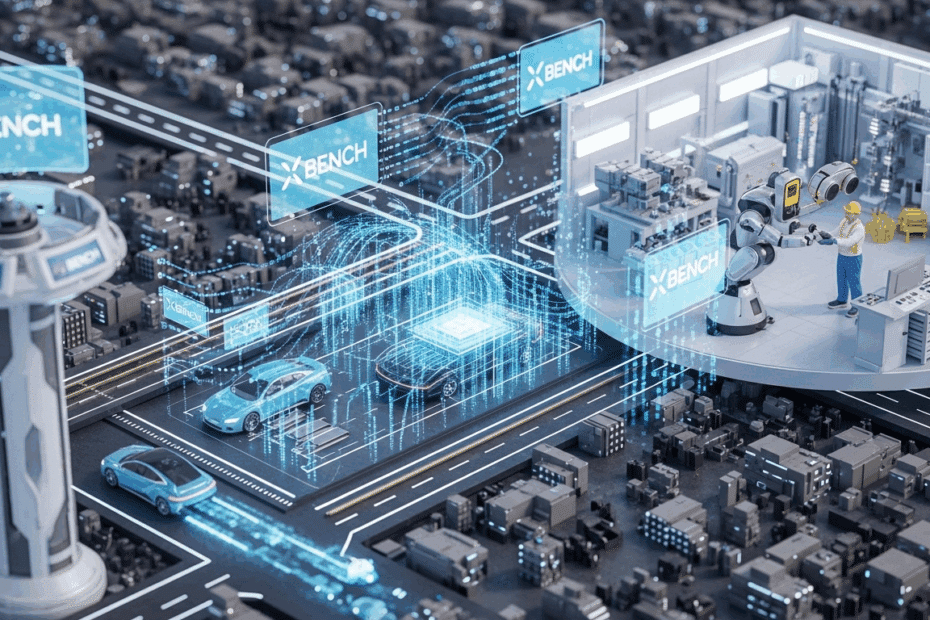

AIの「実力テスト」はどう変わる?新しい評価ツール「xbench」が登場!

こんにちは、AI技術を分かりやすくお伝えするジョンです。最近、AIの進化って本当に目覚ましいですよね!チャットAIや画像生成AIなど、新しい技術が次々と登場して、「どのAIが本当に賢いのかな?」「実際に私たちの生活や仕事で役立ってくれるAIはどれだろう?」なんて、ワクワクしながらもちょっと迷ってしまうことはありませんか?

実は、AIたちにも「実力テスト」のようなものがあるんです。これを専門用語で「ベンチマーク」と呼んだりします。学校のテストで生徒の学力を測るように、ベンチマークを使ってAIがどれだけ賢いか、どんなことができるかを評価するわけですね。でも、この「AIのテスト」にも、最近ちょっとした課題が出てきているんです。

今のAIテストの「困ったところ」

今のAI向けのテストの多くは、問題が公開されていることが多いんです。そうすると、どうなると思いますか?

賢いAI開発者さんたちは、その公開されたテスト問題を使って、自分のAIを「特訓」させちゃうことがあるんですね。まるで、試験前に過去問を徹底的に解いて対策するみたいに。そうすると、AIはそのテストではすごく良い点を取るけれど、それが本当にAIの「地力」なのか、それとも「テスト慣れ」しただけなのか、ちょっと分かりにくくなってしまうんです。これじゃあ、本当に実力のあるAIを見極めるのが難しくなっちゃいますよね。

新しい挑戦者「xbench」って何?

そんな課題を解決しようと登場したのが、中国の投資会社「洪杉資本グループ(HSG、旧セコイア・キャピタル・チャイナ)」が開発した「xbench(エックスベンチ)」という新しいAI評価ツールです。

このxbenchの大きな特徴は、主に以下の2つです。

- 「実世界のタスク」でAIを評価する

xbenchは、AIが単に知識クイズに答えられるかだけでなく、実際に私たちの周りで起こるような課題や作業をどれだけ上手にこなせるか、という「実践力」を重視して評価します。これは、従来のテストとはちょっと違う、新しい視点ですよね。 - テスト内容が「常に新しく」なる

もう一つのポイントは、テスト内容が定期的に更新されること。これにより、AI開発会社が事前にテスト問題を予測して対策する「ヤマ張り」が難しくなります。つまり、AIが持つ、より一般的な問題解決能力が試されるようになるわけです。

HSGは、このxbenchの一部、例えば「科学的な質問に答える能力を測るテスト(xbench-Science QA)」や「情報を深く検索する能力を測るテスト(xbench-DeepSearch)」を、オープンソース(誰でも自由に利用したり、改良したりできる仕組み)として公開しました。これにより、より多くの人の目でxbenchが改善され、AIコミュニティ全体にとって価値あるものになることを目指しているそうです。

専門家はどう見てる?xbenchへの期待と課題

AIの専門家たちも、この新しいxbenchに注目しています。カウンターポイント・リサーチ社のモヒト・アグラワル氏は、「AIモデルは従来のベンチマークでは測りきれないほど成長しており、特に推論(物事を筋道立てて考える力)のような主観的な分野ではその傾向が強い。xbenchは、そのギャップを埋めるための時宜を得た試みだ」と述べています。より現実社会に即したAIの能力評価への第一歩として期待されているんですね。

ただ、課題も指摘されています。

- 主観的な能力の評価は難しい

例えば「推論能力」や「創造性」といった、答えが一つではない能力をどうやって公平に点数化するのかは、とても難しい問題です。 - 評価に「偏り(バイアス)」が入るかも?

テストを作る人の文化的な背景や専門分野によって、評価基準に無意識の偏りが生まれてしまう可能性も考えられます。 - 維持・更新の大変さ

テストを常に最新の状態に保ち、専門家による評価を続けるのは、かなりの労力とコストがかかるかもしれません。

AIの「テスト」はもっと進化が必要?

アマルガム・インサイツ社のCEOであるヒョン・パーク氏は、xbenchのような動的なベンチマークの必要性は認めつつも、さらに踏み込んだ意見を述べています。

「ベンチマークは、ただ更新されるだけでなく、時代に合わせて内容そのものが変わっていく必要がある」とのこと。AIモデルは月単位、いえ、週単位で進化しているので、テストもそれに対応して進化し続けなければならない、というわけです。

また、パーク氏は、AIが技術的に何かを「できる」ことと、それを実社会のタスクで「うまく使いこなせる」ことは別問題だと指摘しています。例えば、最近の研究では、LLM(大規模言語モデルといって、たくさんの文章を学習して賢くなったAIのことです)が、関連する技術的な能力は持っていても、特定の実践的なタスクでは意外とうまく機能しないことが示されたそうです。難しい計算はできても、どの計算式を使えば問題が解けるのか分からない、といったイメージでしょうか。

さらに、私たちユーザーにとっては、AIモデルがどれだけ複雑な問題を解けるかという「AIモデルの規模感や複雑さ」をなんとなくでも理解しておくことが大切だとも言っています。なぜなら、解きたい問題の難易度に対して、適切な規模のAIモデルを選ぶことが、コストを大きく左右する場合があるからです。大きな問題にはパワフルなAI、小さな問題にはもっとコンパクトなAI、といった使い分けですね。

AI開発競争とベンチマークの裏側

AI開発の世界は、今や数十億ドル規模の巨大市場。企業間の競争は非常に激しくなっています。そのため、自社のAIを少しでも良く見せようと、ベンチマークで高得点を取るために「特別な工夫」をするインセンティブが働きやすい状況でもある、と専門家は指摘しています。公平で信頼できる評価の仕組み作りは、本当に難しいけれど大切なことなんですね。

筆者のちょっとした感想

AIの進化のスピードには本当に驚かされますね。今回のxbenchのような新しい評価の試みは、AIの「本当の実力」を測る上でとても重要だと感じました。私たちユーザーも、ただテストの点数を見るだけでなく、AIが実際にどんな場面で、どのように役立ってくれるのかをしっかり見極める目を養っていく必要があるのかもしれませんね。

この記事は、以下の元記事をもとに筆者の視点でまとめたものです:

AI benchmarking tools evaluate real world

performance