AIクリエーターの道 ニュース:RAG、それはLLMの弱点を克服する鍵!Nvidia NeMo Retrieverで検索拡張生成を実現し、AIの未来を切り開こう。 #NvidiaNeMo #RAG #生成AI

🎧 音声で聴く

時間がない方は、こちらの音声でポイントをチェックしてみてください。

📝 テキストで読む

じっくり読みたい方は、以下のテキスト解説をご覧ください。

Retrieval-Augmented Generation(RAG)とは?NVIDIA NeMo Retrieverの基礎を解説

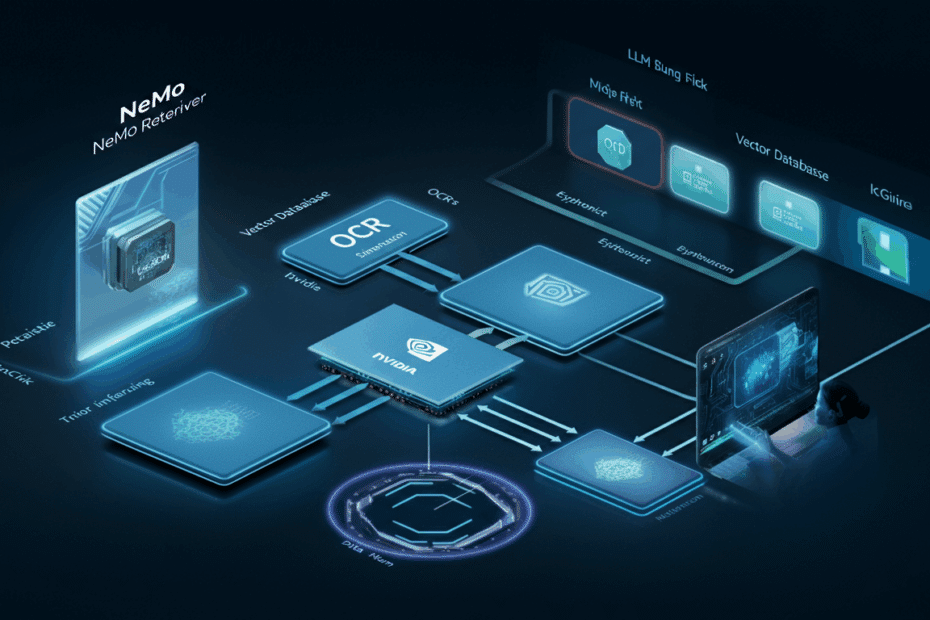

こんにちは、Jonです。AIやテクノロジーの最新トピックを、初心者の方にもわかりやすくお届けするブログへようこそ。今日は、Retrieval-Augmented Generation(略してRAG)と呼ばれる技術について、NVIDIAのNeMo Retrieverを軸に解説します。RAGは、AIの生成機能に検索(Retrieval)を組み合わせる手法で、大規模言語モデル(LLM:Large Language Model、膨大なテキストデータを学習したAIモデル)がより正確な回答を出すための仕組みです。たとえば、チャットボットがユーザーの質問に対して、外部の知識をリアルタイムで調べてから応答するようなイメージです。

この記事のきっかけは、2025年8月19日にInfoWorldで公開された記事「Retrieval-augmented generation with Nvidia NeMo Retriever」です。この記事では、NVIDIAのNeMo Retrieverを使ってPDFファイルを素早く処理し、レポートを生成する例が紹介されています。では、まずはRAGの基本から見ていきましょう。

RAGの仕組みを簡単に

RAGは、単なるAIの生成(Generation)ではなく、信頼できる情報を「検索(Retrieval)」して取り入れ、それを基に回答を生成します。これにより、AIが持っていない最新情報や専門知識を活用できるようになります。たとえば、LLM単独だと古いデータしか知らない場合でも、RAGならウェブやドキュメントから最新情報を引き出せます。

- Retrieval部分:質問に関連するデータを検索・抽出。

- Augmented部分:検索結果をLLMに追加して強化。

- Generation部分:強化された情報を基に、自然なテキストを生成。

NVIDIAのNeMo Retrieverは、このRAGを支えるツールの一つで、生成AIのマイクロサービスとして提供されています。NVIDIAの公式開発者サイトによると、NeMo Retrieverは高い精度の情報検索を実現し、データプライバシーを重視したリアルタイム応答を可能にします。

NVIDIA NeMo Retrieverの最新アップデートと実用例

NeMo Retrieverは、NVIDIAのNeMoフレームワークの一部で、大規模言語モデルやマルチモーダル(テキストだけでなく画像や音声も扱う)AIの開発を支援します。GitHubのリポジトリでは、NeMoが研究者や開発者向けのスケーラブルな生成AIフレームワークとして紹介されており、2025年5月19日に更新された内容では、LLMや音声AIの構築に焦点を当てています。

最近のニュースとして、2025年8月19日にInfoWorldで報じられたように、NeMo RetrieverのモデルとRAGパイプラインは、PDFの取り込みとレポート生成を効率的にこなします。これは「plan-reflect-refine」というアーキテクチャ(計画・反省・洗練のプロセス)を活用したもので、AIの出力品質を高めています。また、同じくInfoWorldのハンズオン記事(2025年8月16日頃公開)では、実際の操作例が詳しく解説されており、初心者でも試しやすい点が強調されています。

2025年の主な更新点

2025年に入ってからの更新として、NVIDIAの技術ブログでは、2025年8月上旬(約2週間前)に「How to Enhance RAG Pipelines with Reasoning Using NVIDIA Llama Nemotron Models」が公開されました。ここでは、ユーザーのクエリが曖昧な場合でも、推論(Reasoning)を加えてRAGを強化する方法が説明されています。たとえば、明示的でない質問に対して、AIが意図を推測しつつ正確な情報を検索するアプローチです。

さらに、2025年7月1日にblockchain.newsで発表された「NVIDIA’s Llama 3.2 NeMo Retriever Enhances Multimodal RAG Pipelines」によると、Llama 3.2 NeMo Retrieverというマルチモーダル埋め込みモデルが導入され、テキストと視覚データを統合してRAGの効率と精度を向上させています。これにより、企業向けのAIアプリケーションで画像や動画を扱うケースが増えるとされています。また、2025年7月5日のragaboutit.comの記事では、このモデルが企業AIのRAG展開を再定義する可能性が議論されており、従来のRAGシステムの失敗率(約80%)を減らす突破口として注目されています。

X(旧Twitter)上の投稿からも、NeMo関連の話題が活発で、2025年8月19日や20日のポストでは、NeMo-RL(NeMoの強化学習版)のバージョン0.3がリリースされ、トレーニング効率を向上させるMegatron-Coreのサポートが追加されたことが共有されています。これらは、大規模モデルのトレーニングをGPU最適化で高速化するもので、RAGの基盤強化につながります。

実用例:PDF処理とレポート生成

InfoWorldの記事を基に、NeMo Retrieverの実用例を見てみましょう。たとえば、ビジネス文書としてPDFを入力すると、NeMo Retrieverは内容を検索・抽出してLLMに渡し、要約レポートを自動生成します。これにより、時間がかかる手作業をAIが代行します。NVIDIAの製品ページ(2025年7月13日更新)では、NeMoがエンドツーエンドのプラットフォームとして、LLMや視覚言語モデル(VLM)の開発をサポートしている点が強調されており、RAGアプリの構築が容易です。

NeMo Retrieverの将来と企業活用のポイント

NVIDIAの技術ブログ(2023年11月28日公開の古い記事ですが、基盤として参照)では、Retrieval QA Embedding Modelを使って企業向けRAGアプリを構築する方法が紹介されており、次世代の生産性ツールとしてLLMの重要性を指摘しています。2025年の更新では、マルチモーダル対応が進んでおり、公式発表に基づくと、2025年中にさらなる機能拡張が予定されています。たとえば、Llama Nemotronモデルを使った推論強化は、曖昧クエリの扱いを改善するロードマップの一部です。

企業活用のポイントとして:

- データプライバシーの確保:NeMo Retrieverは最大限のプライバシーを重視。

- リアルタイム応答:高精度の検索で即時インサイトを提供。

- カスタマイズ性:NVIDIAのNeMoプラットフォームで、LLMやVLMを独自に開発可能。

ただし、導入時は専門知識が必要なので、NVIDIAのドキュメントやチュートリアルを活用することをおすすめします。

まとめとして、NVIDIAのNeMo RetrieverはRAG技術を身近にし、AIの正確性を高める強力なツールです。最新の更新でマルチモーダル対応が進み、企業での実用化が加速しています。私自身、こうした技術が日常の業務を変える可能性にワクワクしていますが、まずは公式ドキュメントから試してみてくださいね。

この記事は、以下の公開情報を参照し、筆者が事実確認を行ったうえで構成しました:

- Retrieval-augmented generation with Nvidia NeMo Retriever | InfoWorld

- NeMo Retriever | NVIDIA Developer

- GitHub – NVIDIA/NeMo

- Build Custom Generative AI | NVIDIA NeMo

- How to Enhance RAG Pipelines with Reasoning Using NVIDIA Llama Nemotron Models | NVIDIA Technical Blog

- NVIDIA’s Llama 3.2 NeMo Retriever Enhances Multimodal RAG Pipelines

- The Multimodal RAG Revolution: How NVIDIA’s Llama 3.2 NeMo Retriever Is Redefining Enterprise AI