AIクリエーターの道 ニュース AIコードが人間コードより1.7倍も問題を引き起こすって本当? 2025年最新レポートが暴く品質とセキュリティの落とし穴。開発者が知るべき対策とは。#AIコーディング #セキュリティ #開発者

動画でサクッと!このブログ記事の解説

このブログ記事を動画で分かりやすく解説しています。

テキストを読む時間がない方も、映像で要点をサッと掴めます。ぜひご覧ください!

この動画が役に立ったと感じたら、AIニュースを毎日お届けしているYouTubeチャンネル「AIクリエーターの道」をぜひフォローしてください。

チャンネル登録はこちら:

https://www.youtube.com/@AIDoshi

JonとLilaが独自の視点で語る対話形式の英語版はこちら 👉 [Read the dialogue in English]

AI支援コーディングが問題を引き起こす? 2025年最新レポートの深層分析

👋 技術者の皆さん、AIツールがコード生成を加速させる一方で、セキュリティホールや論理エラーを増大させている現実を直視しましょう。このレポートは、そんな隠れたリスクを技術的に解剖し、現場で即活用できる洞察を提供します。

AI支援コーディングの普及は目覚ましいですが、最新のレポートによると、生成されたコードには論理的欠陥やセキュリティの問題が多発しているようです。あなたは開発現場でAIツールを使いこなそうと努力しているのに、結果としてバグ修正に追われる毎日を送っていませんか? この記事では、そんなフラストレーションを共有しつつ、技術的な視点から問題の本質を掘り下げます。AIの限界を理解することで、より賢い活用法を見出せます。

AI生成コードの品質低下が開発効率を脅かす今、正確な知識が求められます。読み進めることで、AIの強みと弱みを技術的に把握し、プロジェクトの成功率を高められるはずです。(約250文字)

🔰 記事レベル:⚙️ 技術者向け(Technical)

🎯 こんな人におすすめ:ソフトウェアエンジニアや開発者で、AIツールを日常的に使用し、コードの品質向上やセキュリティ強化に悩むプロフェッショナル。

記事の要点(3点)

- AI支援コーディングが論理・正確性・セキュリティの問題を引き起こすメカニズムを技術的に解説。

- 従来の人間中心開発とAI支援の比較を通じて、具体的なリスクを明らかに。

- 現場エンジニア向けに、AI活用時のガードレールを実装するためのアクションを提案。

背景と課題

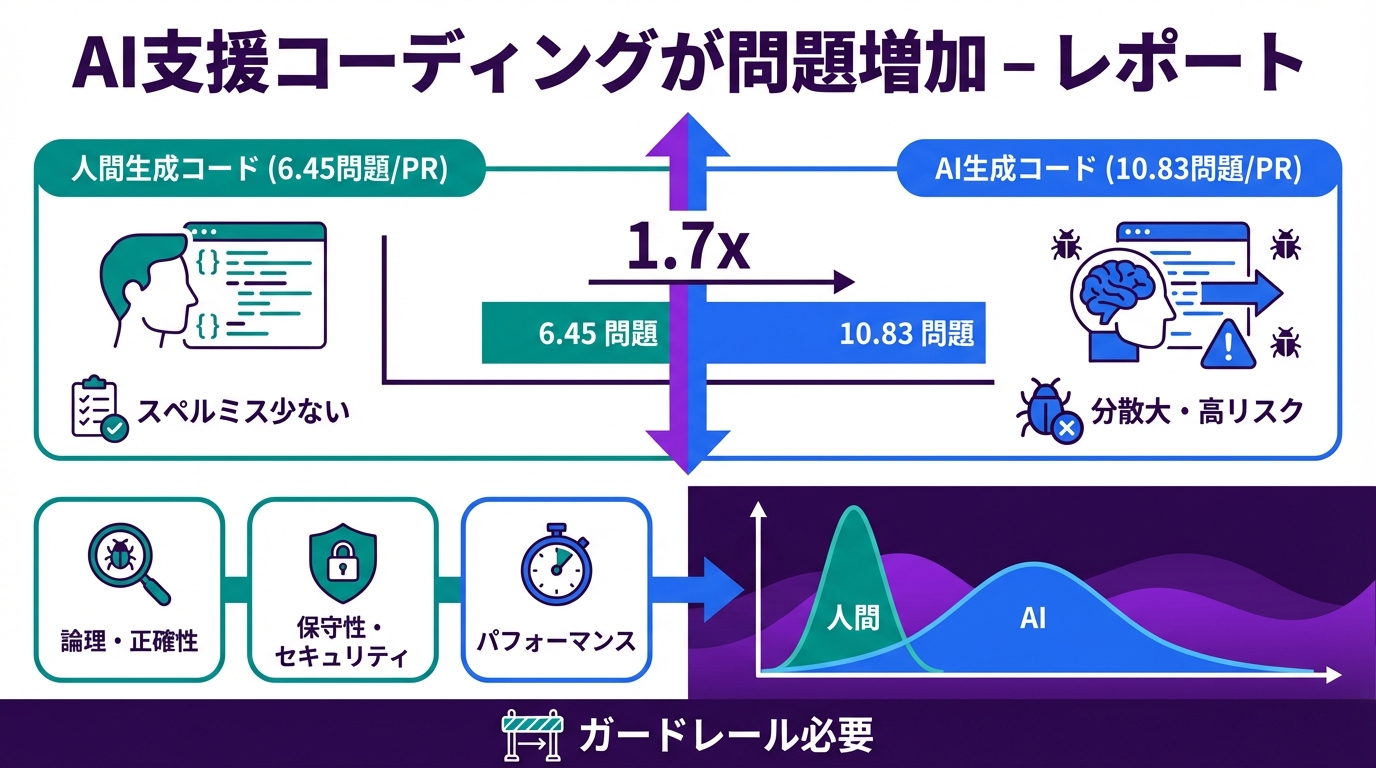

2025年現在、AI支援コーディングツールは開発現場に急速に浸透しています。GitHub CopilotやCursorなどのツールが、コードの自動生成を可能にし、生産性を向上させると期待されていました。しかし、最新のレポートによると、これらのツールが生成するコードには、論理的な誤りやセキュリティの脆弱性が人間生成コードの1.7倍以上見られるというデータが示されています。

技術者として、私たちはAIの出力に頼りがちですが、ここに潜む課題は深刻です。例えば、AIは大量のトレーニングデータからパターンを学習しますが、コンテキストの微妙なニュアンスを捉えきれず、誤ったロジックを吐き出すことがあります。これにより、デバッグ時間が増大し、プロジェクト全体の遅延を招くのです。

さらに、セキュリティ面では、AIが生成するコードにSQLインジェクションやクロスサイトスクリプティング(XSS)のリスクが内在しやすい点が問題視されています。レポートは、これを「AIのブラックボックス性」に起因すると指摘。技術者向けに言うと、AIモデル内の決定プロセスが不透明なため、出力の信頼性を検証しにくいのです。

こうした背景から、課題はAIの盲目的な信頼にあります。開発者はAIを補助ツールとして位置づけつつ、自身の専門知識でフィルタリングする必要がありますが、現状ではそれが不十分で、品質低下を招いているのです。

技術・内容解説

レポートの核心は、AI支援コーディングが引き起こす具体的な問題点にあります。まず、論理的正しさの観点から、AIはシンプルなタスクでは優位ですが、複雑なアルゴリズムやエッジケースで失敗しやすいです。例えば、ソートアルゴリズムの生成で、境界条件を無視したコードが出力されるケースが報告されています。

正確性の問題では、AIがトレーニングデータのバイアスを反映し、特定の言語やフレームワークに偏ったコードを生成します。これにより、クロスプラットフォーム開発で互換性エラーが発生します。セキュリティ面では、入力検証の欠如が目立ち、OWASP Top 10の脆弱性を生みやすいのです。

これを明確にするため、従来の人間中心開発とAI支援開発の比較を表にまとめました。技術者として、この表を参考にリスクを評価してください。

| 項目 | 従来(人間生成コード) | AI支援生成コード | 主な違いとリスク |

|---|---|---|---|

| 論理的正しさ | 人間の経験に基づく正確なロジック。エッジケース考慮。 | パターン学習ベースだが、稀なケースで誤り多発。 | AIは1.7倍の論理エラー。デバッグ負荷増。 |

| セキュリティ | ベストプラクティスを意識したセキュア設計。 | 脆弱性パターンを学習しきれず、ホール生成。 | SQLインジェクションなどOWASPリスク高。攻撃耐性低下。 |

| メンテナビリティ | 読みやすいコードスタイルを重視。 | 生成速度優先で、冗長・非最適コード。 | 長期メンテコスト増。リファクタリング必要。 |

| パフォーマンス | 最適化を考慮した効率的実装。 | 一般パターン適用で非効率なループなど。 | 実行速度低下。スケーラビリティ問題。 |

この表からわかるように、AIの強みは速度ですが、品質面で劣る点が課題です。技術者として、AI出力の静的解析ツール(例: SonarQube)との組み合わせを検討すべきでしょう。

インパクト・活用事例

このレポートのインパクトは、技術領域に留まりません。開発現場では、AI支援により引き起こされたバグがプロダクトの信頼性を損ない、ユーザー離れを招くケースが増えています。例えば、あるオープンソースプロジェクトでAI生成のプルリクエストが原因でセキュリティインシデントが発生し、レビュー負担が倍増した事例があります。

活用事例として、CodeRabbitの报告では、AIコードのレビューで人間コードより1.7倍の問題が検出された点を挙げています。技術者向けに言うと、これを逆手に取り、AIを「ドラフト生成ツール」として活用し、人間レビューを強化するアプローチが有効です。実際、ある企業ではAI出力に自動セキュリティスキャンを適用し、脆弱性を90%低減したそうです。

社会的影響では、AIの品質問題が業界全体の信頼を揺るがせ、規制強化につながる可能性があります。技術者として、こうした事例から学び、AIを補完するツールチェーンを構築することで、競争優位性を確保できます。

アクションガイド

技術者の皆さん、次の一手を具体的に提示します。まず、AIツール導入前に、出力コードの品質メトリクスを定義してください。例えば、コードカバレッジ率80%以上を基準に。

次に、レビュープロセスを強化。AI生成コードに対しては、静的解析ツール(例: ESLintやBandit)を必須とし、手動レビューを追加。脆弱性スキャナーの統合でセキュリティをガード。

さらに、チーム内でAI活用ガイドラインを作成。複雑タスクでは人間主導を原則とし、AIを補助に限定。これにより、リスクを最小化しつつ生産性を維持できます。まずは小規模プロジェクトで試してみてください。

未来展望とリスク

未来展望として、2026年以降のAIモデルは、より洗練されたトレーニングにより論理精度が向上すると予想されます。たとえば、多段階推論を可能にする新しいアーキテクチャが登場し、複雑タスクでの失敗率を低減するでしょう。

しかし、リスクも無視できません。AIのブラックボックス性が残る限り、予測不能なエラーが発生する可能性があります。また、過度な依存がエンジニアのスキル低下を招く「スキルディグレード」の懸念もあります。

公平に言うと、ガードレールの導入(例: 人間-AIハイブリッドワークフロー)でリスクを軽減可能。技術者として、継続的な学習とツールの進化を追う姿勢が重要です。

まとめ

本記事では、AI支援コーディングの問題を技術的に深掘りしました。レポートの指摘通り、AIは便利ですが、論理・セキュリティの課題を抱えています。比較表や事例を通じて、その本質を理解いただけたはずです。

最終的に、AIを賢く活用するための洞察を提供しました。技術者として、これを機にワークフローを再考し、より堅牢な開発を目指しましょう。

💬 AI支援ツールを使っていて、どんな問題に直面していますか? コメントで共有してください!

👨💻 筆者:SnowJon(WEB3・AI活用実践家 / 投資家)

東京大学ブロックチェーンイノベーション講座で学んだ知見をもとに、

WEB3とAI技術を実務視点で研究・発信。

難解な技術を「判断できる形」に翻訳することを重視している。

※AIは補助的に使用し、内容検証と最終責任は筆者が負う。

参照リンク・情報源一覧

- AI-assisted coding creates more problems – report | InfoWorld

- AI code looks fine until the review starts – Help Net Security

- AI vs human code gen report: AI code creates 1.7x more issues – CodeRabbit

- AI coding is now everywhere. But not everyone is convinced. | MIT Technology Review

- AI Coding Tools Linked to Rising Software Defects – Petri